洞察專注狀態 吳亦超解析深度學習AI偵測技術

【人工智慧跨域研究中心訊】

本校人工智慧跨域研究中心(AI中心)於2025年5月6日舉辦年度首場AI跨域系列講座,特邀國立臺北科技大學電子工程系吳亦超副教授,以「基於深度學習之專注力偵測」為題,分享其在專注力與行為辨識系統之研究成果,並說明神經網路於深度學習中的核心角色。講座內容深入淺出,除介紹神經網路在影像辨識中的應用,也透過實例解析深度學習模型如何精準判斷使用者的專注狀態。

建構深度學習的專注力辨識系統

吳亦超副教授指出,其團隊開發的專注力偵測系統整合「分心」、「疲勞」與「行為」三大模組,能即時判斷使用者的注意力狀態。在分心檢測方面,系統透過頭部姿態分析與視線方向估算,結合攝影機參數與空間座標轉換技術,判斷視線是否偏離焦點。疲勞檢測則利用眼部關鍵點計算 Eye Aspect Ratio(EAR),當達到特定閾值即視為疲勞狀態,並以嘴部動作以提升判斷準確度;至於行為檢測則運用多目標追蹤與配對演算法,將手機、水壺等物體與使用者配對,分析當中的互動行為,提升系統穩定性與實用性。

在技術架構設計上,吳亦超副教授以YOLOv8模型為基礎進行改良,並融入深度卷積(Convolutio Neural Network)和結構重參數化(Re-parameterization)以提升推論效率與即時應用能力。他進一步說明CNN之所以在影像辨識領域中佔有一席之地,關鍵在於其能有效擷取圖像中如邊緣、紋理等特徵,並透過激活函數(如ReLU)與池化(Pooling)等機制,降低資料維度,同時保留關鍵資訊,達到減少運算量與提升辨識準確率的雙重效果。

為協助現場聽眾理解模型運作,吳亦超副教授也透過直觀的圖像範例,解說卷積操作如何模擬人眼對形狀與邊緣的辨識過程,幫助非資訊背景的學生理解AI模型如何「看見」圖像。

聚焦神經網路訓練機制,深化學習原理

吳亦超副教授也介紹神經網路的訓練流程包含初始化權重、設定學習率,根據誤差進行反向調整,最終讓模型學會正確分類或辨識,是神經網路學習的核心。而損失函數(Loss Function)則是量化預測錯誤程度的依據,在模型設計中扮演關鍵角色。以邊界框(Bounding Box)預測為例,研究人員會不斷微調參數,使預測框逐步逼近實際框位置,進而提升辨識精度。

從實作中學習AI的價值

在講座尾聲,吳亦超副教授鼓勵學生們勇於嘗試AI實作,指出現今AI學習資源豐富、門檻逐漸降低。透過如Teachable Machine等可視化工具,即使無程式基礎者依然能嘗試影像辨識任務,從實作中培養AI素養。吳亦超副教授強調,「AI的起點,不在於你懂多少,而在於你是否願意開始動手做。」本場講座成功串聯AI理論與實務應用,帶領師生深入了解深度學習技術在專注力偵測系統中的實踐方式,展現AI技術於跨域應用的龐大潛能。

吳亦超副教授透過公式說明神經網路概念。(照片來源:AI中心)

本場講座參與師生。(照片來源:AI中心)

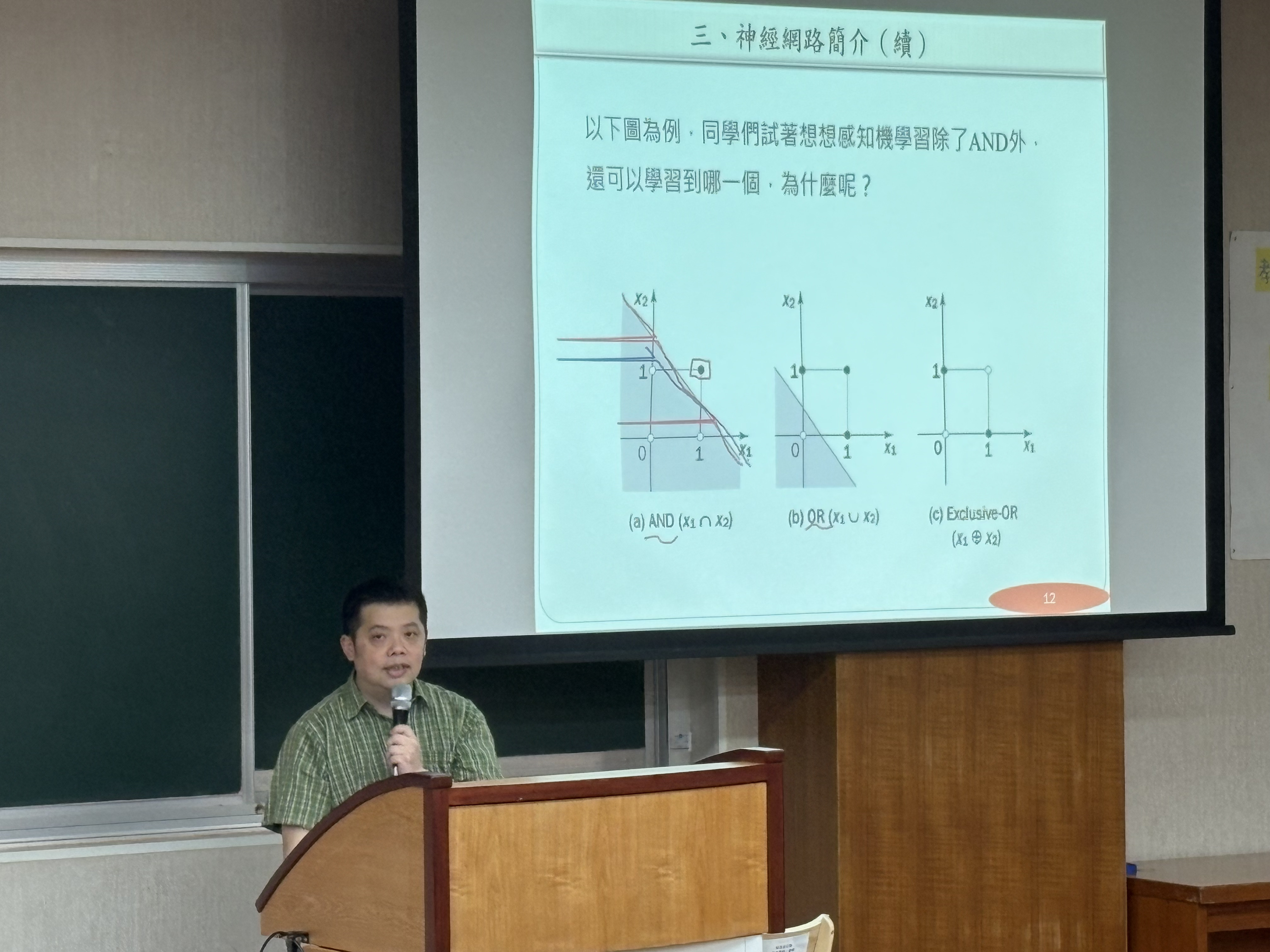

吳亦超副教授透過 AND/OR/XOR 範例,引導學生理解神經網路的線性可分性。(照片來源:AI中心)